Nel mondo del business moderno, i dati rappresentano un asset strategico fondamentale. Le informazioni provenienti da sistemi ERP, CRM, piattaforme di e-commerce e altre fonti digitali alimentano il processo decisionale e l’innovazione.

Tuttavia, raccogliere i dati non basta: è necessario organizzarli, pulirli e renderli fruibili in modo da poter ottenere analisi accurate e vantaggi competitivi. Per fare questo, le aziende adottano metodologie di integrazione dei dati basate su due approcci principali: ETL (Extract, Transform, Load) ed ELT (Extract, Load, Transform).

Questa guida servirà a capire le differenze tra questi metodi, a valutare i benefici in termini di qualità dei dati, performance, scalabilità e costi operativi, e a scegliere la strategia più adatta alle esigenze, sia in ambienti tradizionali che nel cloud.

Una Visione Complessiva: ETL ed ELT per l’Integrazione dei Dati

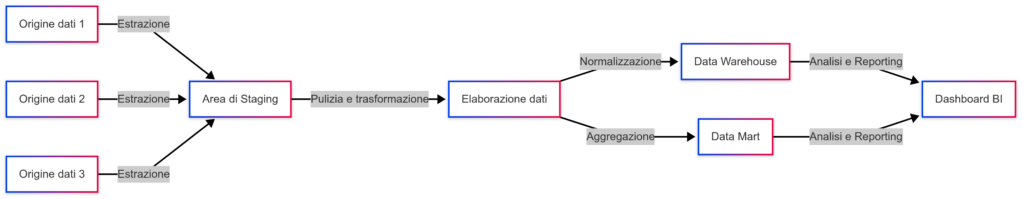

L’approccio ETL, che sta per “Extract, Transform, Load”, è stato a lungo lo standard per l’integrazione dei dati. Questo metodo prevede di estrarre i dati da diverse fonti – siano esse database relazionali, sistemi legacy, file di log o API – trasformarli applicando regole di pulizia, normalizzazione e aggregazione, e infine caricarli in un data warehouse o in un data lake.

Proprio come organizzare un archivio documentale in modo che ogni informazione sia correttamente catalogata e pronta per essere consultata, il processo ETL garantisce che i dati siano di alta qualità prima di essere messi a disposizione per analisi e reporting.

D’altra parte, l’approccio ELT (Extract, Load, Transform) sfrutta le potenzialità dei moderni ambienti cloud. In questo caso, i dati vengono prima estratti e caricati “così come sono” nel sistema di destinazione, e solo successivamente vengono trasformati direttamente all’interno del data warehouse.

Questo metodo è particolarmente vantaggioso quando si lavora con grandi volumi di dati, poiché permette di iniziare l’analisi immediatamente e di sfruttare la scalabilità e la potenza di calcolo offerti dal cloud, rendendo il processo di trasformazione flessibile e dinamico.

Qualità dei Dati, Performance e Analisi dei Costi

Dietro ai processi di ETL ed ELT ci sono alcuni aspetti da considerare che possono rendere il progetto un successo o meno. Dal momento che questi processi vengono utilizzati per integrare dati, aspetti come la qualità, la performance e la gestione dei costi diventano fattori molto importanti sui quali riflettere e fare le opportune considerazioni.

Gestione della Qualità dei Dati

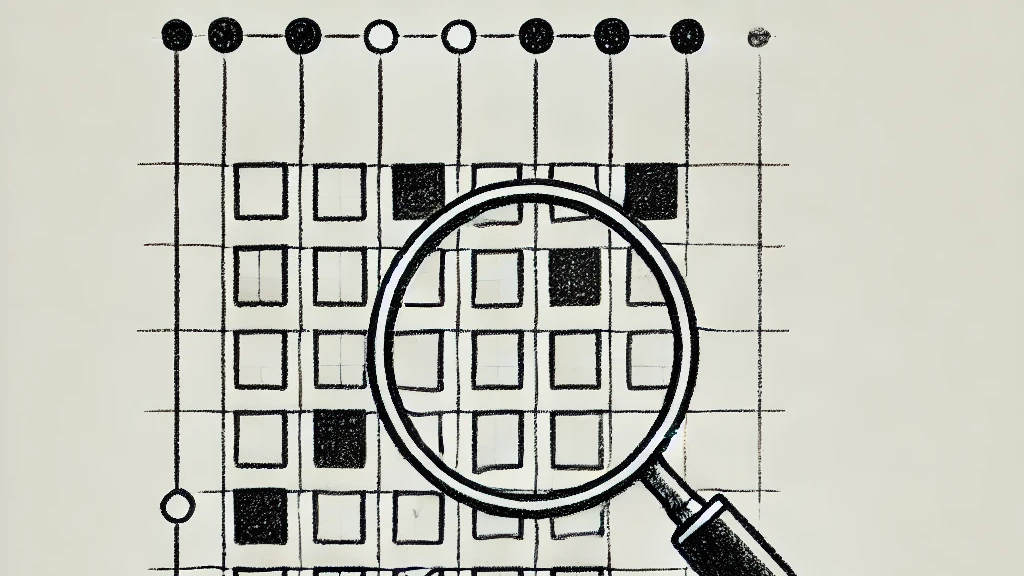

La qualità dei dati è un elemento critico in ogni progetto di integrazione (nel mio articolo precedente si parla proprio dei princìpi alla base della qualità dei dati).

Caricare i dati “as is” significa che dati non ancora puliti vengono inseriti nel sistema, e se non si adottano adeguati meccanismi di monitoraggio, potrebbero emergere errori, duplicazioni o incoerenze che poi rendono più difficile ottenere analisi accurate.

Così, dati imprecisi, incompleti o mal strutturati possono portare a errori nelle analisi e decisioni sbagliate, con conseguenze potenzialmente disastrose per l’azienda.

Ancora, la gestione del data lineage è un’altra area su cui è bene fare le dovute considerazioni. Quando i dati vengono caricati grezzi e poi trasformati, diventa più difficile tracciare con precisione le operazioni effettuate, un aspetto fondamentale per motivi di audit e compliance normativa. Una tracciabilità insufficiente può complicare il debugging e rendere difficile risalire alle cause di eventuali errori.

Nel contesto dei processi ETL, la fase di trasformazione pre-caricamento consente di intervenire prima che i dati vengano immessi nel sistema finale. Durante questa fase è possibile applicare una serie di controlli, quali la rimozione di record incompleti, la correzione di formati errati, la normalizzazione delle informazioni (ad esempio, uniformare il formato delle date o convertire tutte le stringhe in minuscolo) e persino l’arricchimento dei dati mediante l’integrazione di informazioni da fonti esterne. In questo modo, il data warehouse o il data lake riceve esclusivamente dati “puliti”, riducendo notevolmente il rischio che analisi successive siano influenzate da errori o incongruenze.

Nel modello ELT, invece, i dati vengono caricati nel sistema in forma grezza e le trasformazioni vengono eseguite successivamente. Questo approccio richiede quindi l’adozione di strumenti di data profiling e di monitoraggio della qualità dei dati.

Ad esempio, Microsoft Purview è una soluzione unificata di governance dei dati che consente di scoprire, classificare e tracciare i dati, monitorando la qualità e facilitando la gestione della data lineage. Questi strumenti, combinati, offrono un ecosistema completo per garantire che i dati, indipendentemente dall’approccio adottato, siano accurati, coerenti e pronti per supportare decisioni strategiche.

È fondamentale monitorare in tempo reale la qualità dei dati anche dopo il caricamento, in modo da poter intervenire rapidamente in caso di anomalie o errori, e assicurare che il processo di trasformazione mantenga elevati standard qualitativi.

La gestione della qualità dei dati quindi non è solo un’attività tecnica, ma un pilastro strategico che permette all’azienda di basare le proprie decisioni su informazioni affidabili.

Questo miglioramento continuo è indispensabile per dare fiducia agli utenti nella bontà dei dati, così che possano basarsi su di essi per prendere decisioni di business.

Performance e Scalabilità dei Dati

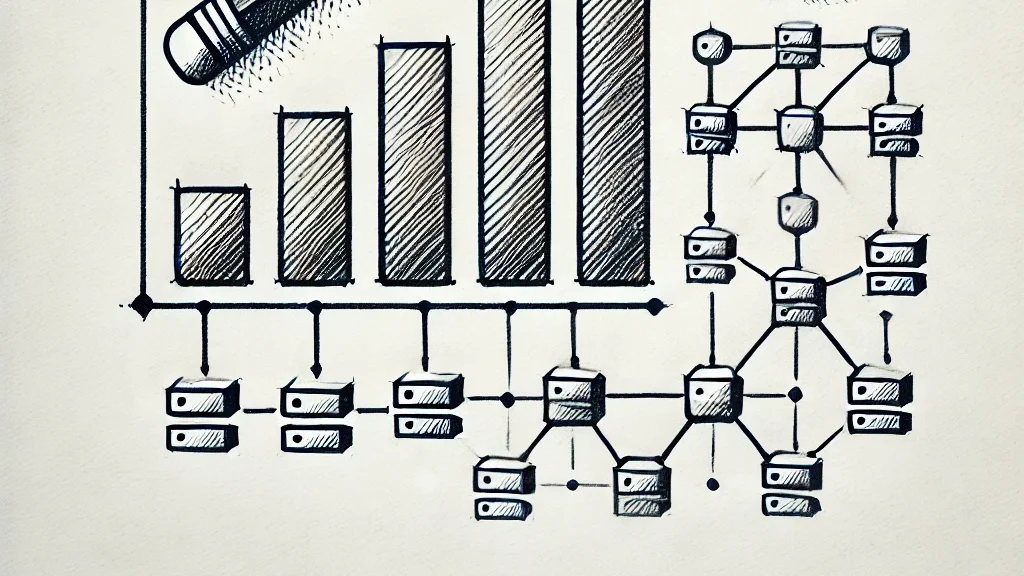

La capacità di elaborare e integrare dati in maniera efficiente è un altro aspetto cruciale. I sistemi ETL tradizionali, spesso implementati su infrastrutture on-premise, possono incontrare problemi di performance quando il volume dei dati cresce.

La fase di trasformazione, essendo eseguita prima del caricamento, può rappresentare un collo di bottiglia se le risorse hardware non sono sufficientemente potenti o se il processo di trasformazione non è ottimizzato. In ambienti in cui i dati aumentano in maniera esponenziale, questo approccio può portare a tempi di elaborazione prolungati e a una maggiore complessità operativa.

Ora, passando al cloud, spesso avviene che (anche se non è una regola) i processi ETL vengano comunque pubblicati su macchine virtuali che pur essendo scalabili non godono della stessa elasticità di un servizio cloud native.

Con l’approccio ELT, invece, l’adozione di soluzioni cloud come Azure Data Factory o AWS Glue offre vantaggi significativi in termini di scalabilità. Le piattaforme cloud permettono di distribuire il carico di lavoro su risorse elastiche, consentendo di elaborare i dati in parallelo. Ciò significa che, anche in presenza di picchi di carico o variazioni improvvise nel volume dei dati, il sistema è in grado di adattarsi dinamicamente, riducendo i tempi di trasformazione e migliorando l’efficienza operativa complessiva.

Questa scalabilità dinamica è particolarmente preziosa per le aziende che operano in mercati altamente competitivi e in rapida evoluzione, dove la rapidità di accesso e l’aggiornamento dei dati possono fare la differenza.

L’adozione di un modello ELT permette inoltre di iniziare l’analisi dei dati quasi immediatamente, grazie al caricamento dei dati grezzi, e di applicare trasformazioni specifiche solo quando richiesto, migliorando così l’esperienza complessiva degli utenti e la velocità di risposta del sistema.

Analisi dei Costi e ROI

Dal punto di vista economico, la scelta tra ETL ed ELT incide significativamente sui costi operativi e sul ritorno sull’investimento (ROI).

Il modello ELT si basa su soluzioni cloud che adottano un modello di costo variabile: si paga in base all’utilizzo effettivo delle risorse. Questo approccio consente una gestione più agile del budget, permettendo all’azienda di scalare le risorse in modo dinamico in base alle esigenze. L’utilizzo di strumenti come il calcolatore prezzi di Azure consente di stimare con precisione i costi e pianificare gli investimenti, garantendo un ROI più rapido e prevedibile. In un contesto in cui le aziende devono gestire volumi di dati crescenti, il modello “pay-per-use” offre una maggiore flessibilità economica, riducendo il rischio di spese eccessive e facilitando l’adattamento alle variazioni del mercato.

L’analisi dei costi non riguarda solo l’investimento iniziale, ma anche la gestione operativa a lungo termine: un sistema che permette trasformazioni rapide e scalabili può tradursi in una maggiore efficienza e in un risparmio significativo in termini di tempo e risorse.

Esempi pratici ed implementazioni con codice

ETL: Un caso pratico in Python

Per rendere il concetto più concreto, consideriamo questo scenario: abbiamo un file CSV in un container su Azure Blob Storage, lo scarichiamo localmente (o lo leggiamo in streaming), eseguiamo trasformazioni in Pandas e salviamo i dati trasformati in Azure SQL Database.

import os

import pandas as pd

from azure.storage.blob import BlobServiceClient

import pyodbc

# Parametri di connessione

STORAGE_CONNECTION_STRING = "DefaultEndpointsProtocol=https;AccountName=xxx;AccountKey=xxx;EndpointSuffix=core.windows.net"

CONTAINER_NAME = "input-container"

BLOB_NAME = "dataset.csv"

SQL_SERVER = "nome_server.database.windows.net"

SQL_DATABASE = "nome_database"

SQL_USERNAME = "username"

SQL_PASSWORD = "password"

# 1. EXTRACT: scaricare (o leggere) il file CSV da Azure Blob Storage

blob_service_client = BlobServiceClient.from_connection_string(STORAGE_CONNECTION_STRING)

container_client = blob_service_client.get_container_client(CONTAINER_NAME)

blob_client = container_client.get_blob_client(BLOB_NAME)

downloaded_blob = blob_client.download_blob()

df_raw = pd.read_csv(downloaded_blob.content_as_text(encoding='utf-8'))

# 2. TRANSFORM: trasformazioni con pandas

# Esempio: aggiungiamo una colonna calcolata in base ad altre colonne

df_raw['nuova_colonna'] = df_raw['colonna_esistente'] * 2

df_transformed = df_raw.dropna() # rimuove i record con valori NaN

# 3. LOAD: scrivere i dati trasformati su Azure SQL Database

# Creiamo la stringa di connessione ODBC

connection_string = f"""

DRIVER={{ODBC Driver 17 for SQL Server}};

SERVER={SQL_SERVER};

DATABASE={SQL_DATABASE};

UID={SQL_USERNAME};

PWD={SQL_PASSWORD};

"""

# Connessione al database

with pyodbc.connect(connection_string) as conn:

cursor = conn.cursor()

# Esempio di creazione tabella di destinazione se non esiste

create_table_sql = """

IF NOT EXISTS (

SELECT * FROM sys.objects

WHERE object_id = OBJECT_ID(N'[dbo].[Destinazione]') AND type in (N'U')

)

BEGIN

CREATE TABLE [dbo].[Destinazione] (

[col1] VARCHAR(100),

[col2] INT,

[nuova_colonna] INT

)

END

"""

cursor.execute(create_table_sql)

conn.commit()

# Inserimento dati riga per riga (non ottimale per grandi volumi, ma semplice come esempio)

insert_sql = "INSERT INTO [dbo].[Destinazione] (col1, col2, nuova_colonna) VALUES (?, ?, ?)"

for index, row in df_transformed.iterrows():

cursor.execute(insert_sql, row['col1'], row['col2'], row['nuova_colonna'])

conn.commit()

print("ETL completato con successo!")

In questo esempio, ogni fase del processo ETL è chiaramente delineata, garantendo che i dati siano pronti per un’analisi accurata e affidabile.

Questo approccio è utile se gran parte della logica di trasformazione è gestita dal codice e quando i dati non sono eccessivamente voluminosi (in caso di dati molto grandi, ci si potrebbe affidare a strumenti più scalabili come Azure Data Factory, Databricks, Spark, ecc.).

ELT: Implementazione in Ambiente Cloud con Microsoft Azure

Nell’approccio ELT (Extract, Load, Transform), il flusso è:

- Extract: i dati vengono estratti dalla sorgente.

- Load: i dati vengono caricati nel data warehouse/data lake (ad es. Azure Synapse, Azure Data Lake Storage).

- Transform: la trasformazione avviene dentro il data warehouse (ad esempio tramite query SQL, stored procedure, Spark su Synapse, ecc.).

Scenario: carichiamo il file CSV (raw) in una tabella di staging di Azure Synapse (o SQL Database) e poi applichiamo le trasformazioni direttamente tramite query SQL.

import pandas as pd

from azure.storage.blob import BlobServiceClient

import pyodbc

# Parametri di connessione

STORAGE_CONNECTION_STRING = "DefaultEndpointsProtocol=https;AccountName=xxx;AccountKey=xxx;EndpointSuffix=core.windows.net"

CONTAINER_NAME = "input-container"

BLOB_NAME = "dataset.csv"

SQL_SERVER = "nome_server.database.windows.net"

SQL_DATABASE = "nome_database"

SQL_USERNAME = "username"

SQL_PASSWORD = "password"

# 1. EXTRACT

blob_service_client = BlobServiceClient.from_connection_string(STORAGE_CONNECTION_STRING)

container_client = blob_service_client.get_container_client(CONTAINER_NAME)

blob_client = container_client.get_blob_client(BLOB_NAME)

downloaded_blob = blob_client.download_blob()

df_raw = pd.read_csv(downloaded_blob.content_as_text(encoding='utf-8'))

# 2. LOAD: Caricamento del dataset RAW in una tabella di staging (StagingTable) su Azure Synapse / SQL DB

connection_string = f"""

DRIVER={{ODBC Driver 17 for SQL Server}};

SERVER={SQL_SERVER};

DATABASE={SQL_DATABASE};

UID={SQL_USERNAME};

PWD={SQL_PASSWORD};

"""

with pyodbc.connect(connection_string) as conn:

cursor = conn.cursor()

# Creazione tabella di staging se non esiste

create_staging_sql = """

IF NOT EXISTS (

SELECT * FROM sys.objects

WHERE object_id = OBJECT_ID(N'[dbo].[StagingTable]') AND type in (N'U')

)

BEGIN

CREATE TABLE [dbo].[StagingTable] (

[col1] VARCHAR(100),

[col2] INT

-- aggiungere altre colonne secondo lo schema del CSV

)

END

"""

cursor.execute(create_staging_sql)

conn.commit()

# Inserimento dati raw in staging table

insert_staging_sql = "INSERT INTO [dbo].[StagingTable] (col1, col2) VALUES (?, ?)"

for index, row in df_raw.iterrows():

cursor.execute(insert_staging_sql, row['col1'], row['col2'])

conn.commit()

# 3. TRANSFORM: Trasformazioni direttamente in SQL

# Esempio di creazione di una tabella di destinazione e spostamento dei dati trasformati:

create_final_sql = """

IF NOT EXISTS (

SELECT * FROM sys.objects

WHERE object_id = OBJECT_ID(N'[dbo].[FinalTable]') AND type in (N'U')

)

BEGIN

CREATE TABLE [dbo].[FinalTable] (

[col1] VARCHAR(100),

[col2] INT,

[calculated_col] INT

)

END

"""

cursor.execute(create_final_sql)

conn.commit()

# Inseriamo nella FinalTable i dati trasformati tramite una query SQL

# Esempio: [calculated_col] = col2 * 2

transform_sql = """

INSERT INTO [dbo].[FinalTable] (col1, col2, calculated_col)

SELECT

col1,

col2,

col2 * 2 AS calculated_col

FROM [dbo].[StagingTable]

WHERE col2 IS NOT NULL -- esempio di filtro

"""

cursor.execute(transform_sql)

conn.commit()

print("ELT completato con successo!")

Punti chiave:

La trasformazione dei dati (TRANSFORM) avviene successivamente e direttamente nel motore di destinazione (SQL Data Warehouse / Synapse / DB).

E’ vantaggioso quando si sfruttano le funzionalità di calcolo del data warehouse (ad esempio query distribuite, engine MPP di Synapse, ecc.) per gestire grandi volumi e trasformazioni complesse.

Problematiche e Sfide dell’Approccio ELT

Nonostante i numerosi vantaggi, l’approccio ELT presenta alcune criticità che è importante considerare:

Una delle problematiche principali è la qualità dei dati. Caricare i dati “as is” significa che dati non ancora puliti vengono inseriti nel sistema, e se non si adottano adeguati meccanismi di monitoraggio, potrebbero emergere errori, duplicazioni o incoerenze che poi rendono più difficile ottenere analisi accurate.

Un’altra sfida è la complessità delle trasformazioni on-demand. Trasformare i dati direttamente nel data warehouse richiede una notevole potenza di calcolo e, se le query non sono ben ottimizzate, il sistema potrebbe soffrire di rallentamenti. La gestione della concorrenza e l’ottimizzazione delle query diventano elementi critici per mantenere elevate le performance.

La gestione del data lineage è un’altra area problematica. Quando i dati vengono caricati grezzi e poi trasformati, diventa più difficile tracciare con precisione le operazioni effettuate, un aspetto fondamentale per motivi di audit e compliance normativa. Una tracciabilità insufficiente può complicare il debugging e rendere difficile risalire alle cause di eventuali errori.

Inoltre, l’adozione del modello ELT comporta anche sfide in termini di costi operativi. Se le trasformazioni richiedono risorse intensive e non sono ottimizzate, i costi possono aumentare rapidamente. Il modello “pay-per-use” dei servizi cloud offre flessibilità, ma necessita di una gestione attenta per evitare spese eccessive.

Infine, la sicurezza e la conformità rappresentano un punto critico. Caricare dati grezzi nel sistema può esporre informazioni sensibili prima che vengano applicate misure di mascheramento o crittografia, aumentando il rischio di violazioni della privacy e complicando la conformità a normative come il GDPR o il CCPA.

Perché Dovresti Interessarti a ETL ed ELT

Comprendere le differenze tra ETL ed ELT è fondamentale per chiunque voglia massimizzare il valore dei propri dati. Se sei un responsabile IT, un data analyst o un manager che desidera prendere decisioni basate su dati accurati, scegliere il giusto approccio all’integrazione dei dati può fare la differenza tra un sistema inefficiente e una soluzione strategica che alimenta il successo aziendale.

Con il metodo ETL puoi garantire che i dati siano già puliti e strutturati prima di essere caricati, mentre l’approccio ELT ti permette di sfruttare la flessibilità e la scalabilità offerte dalle tecnologie cloud per gestire grandi volumi di dati in modo dinamico.

La corretta gestione della qualità dei dati, le performance e la scalabilità dei processi, nonché un’analisi accurata dei costi, sono elementi essenziali per ottenere un ROI positivo e trasformare i dati in un asset competitivo.

Se desideri approfondire ulteriormente questi temi o implementare una soluzione su misura per la tua azienda, non esitare a contattarmi.

Link di riferimento: